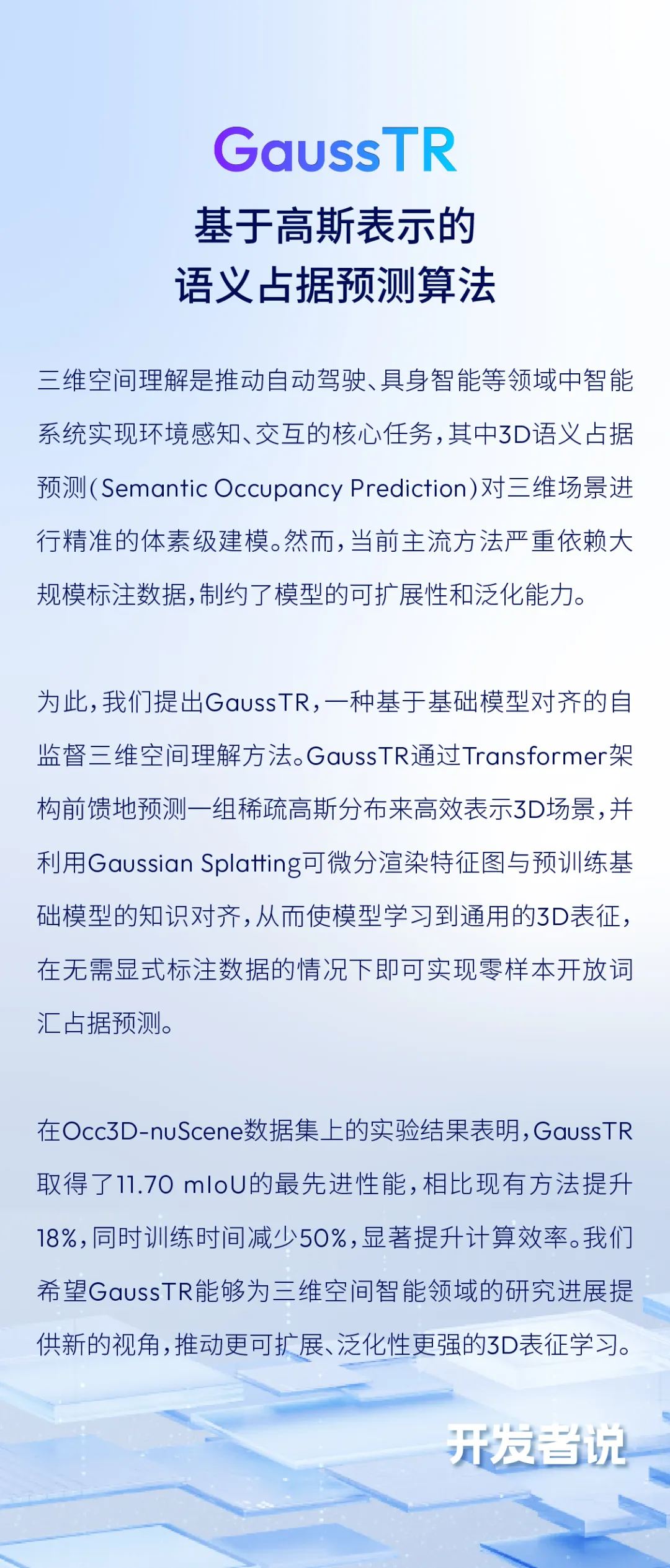

CVPR 2025 | 通向自监督三维空间理解——基于高斯表示的语义占据预测算法GaussTR

2025/03/14

• 论文链接:

https://arxiv.org/pdf/2412.13193

• 项目主页:

https://hustvl.github.io/GaussTR/

概述

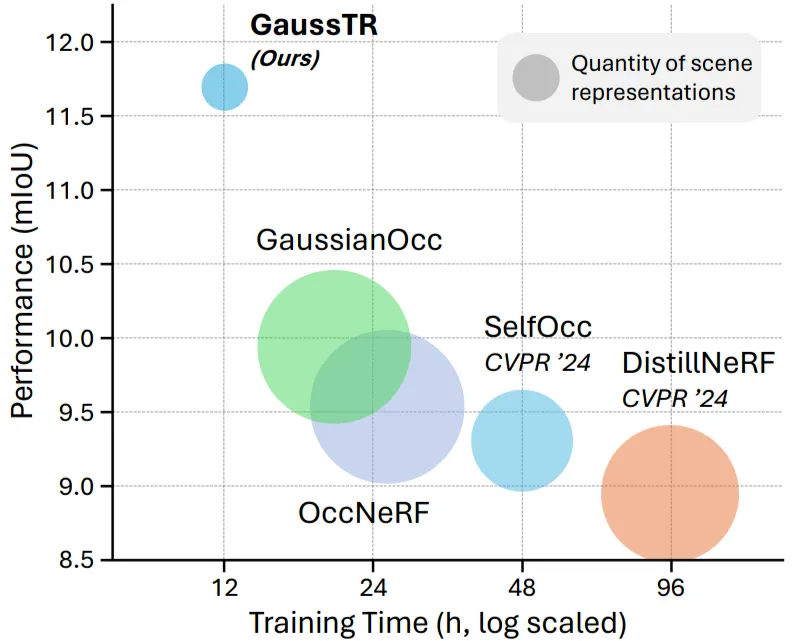

三维空间理解是推动自动驾驶、具身智能等领域中智能系统实现环境感知、交互的核心任务,其中3D语义占据预测 (Semantic Occupancy Prediction) 对三维场景进行精准的体素级建模。然而,当前主流方法严重依赖大规模标注数据,制约了模型的可扩展性和泛化能力。为此,我们提出GaussTR,一种基于基础模型对齐的自监督三维空间理解方法。GaussTR通过Transformer架构前馈地预测一组稀疏高斯分布来高效表示3D场景,并利用Gaussian Splatting可微分渲染特征图与预训练基础模型的知识对齐,从而使模型学习到通用的3D表征,在无需显式标注数据的情况下即可实现零样本开放词汇占据预测。在Occ3D-nuScene数据集上的实验结果表明,GaussTR取得了11.70mIoU的最先进性能,相比现有方法提升18%,同时训练时间减少50%,显著提升计算效率。我们希望GaussTR能够为三维空间智能领域的研究进展提供新的视角,推动更可扩展、泛化性更强的3D表征学习。

基于基础模型对齐的3D表征学习

近年来,2D视觉基础模型,如CLIP、DINO等,已取得突破性进展,而自监督3D空间理解仍受限于大规模3D数据集的获取困难与3D表征的复杂性。在3D语义占据预测任务中,现有的有监督方法依赖大规模体素级标注,不仅标注成本高昂,也难以扩大到更大规模的模型量级。受RenderOcc的启发,一些自监督方案尝试通过基于SAM生成的语义掩码伪标签来间接监督3D表征。然而,该类方法仍限于学习SAM生成的预定义的类别概率,限制了通用3D表征的学习,难以适应自动驾驶等现实应用中不可忽视的分布外 (Out-of-Distribution) 场景。同时,基于密集体素的建模方式也带来了冗余计算开销大、难以捕捉高级语义信息等问题。

受到3D Gaussian Splatting (GS) 技术在场景重建领域的成功应用启发,GaussTR采用稀疏高斯作为3D建模方式,利用GS在2D与3D域间的跨模态表征一致性,实现2D视觉基础模型的知识迁移到前馈预测的稀疏、非结构化的通用3D高斯表征中。借助2D视觉基础模型获得可扩展性和泛化性,实现自监督3D空间理解与零样本开放词汇推理。

算法架构

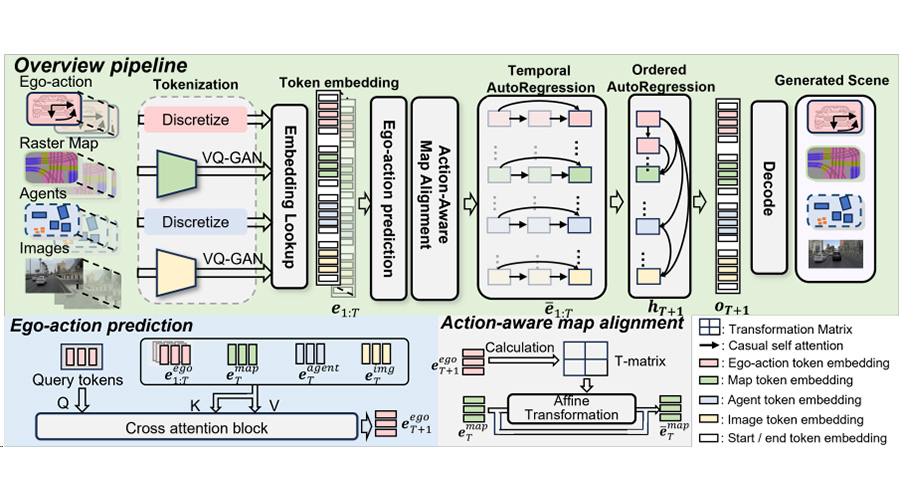

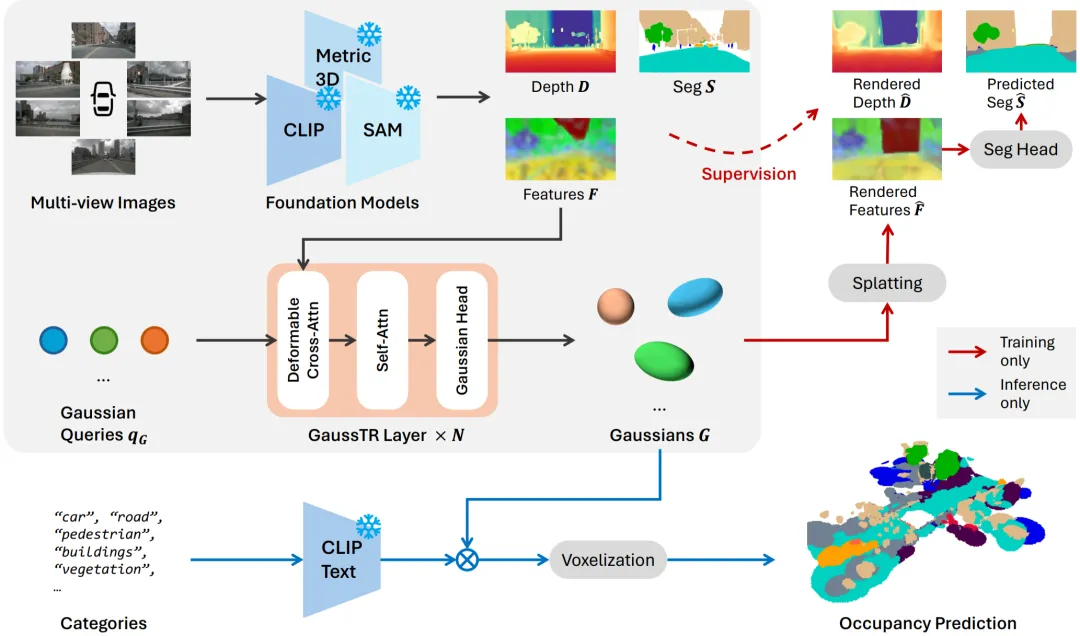

GaussTR作为基于自监督学习的3D场景理解框架,整体架构可分为前馈高斯建模、基础模型对齐监督、开放词汇占据预测三个阶段。

“

前馈高斯建模

GaussTR以多视角图像作为输入,首先通过CLIP和Metric3D V2提取全局语义特征和深度信息构建几何先验。由于CLIP的视觉局部特征较弱,GaussTR引入FeatUp模块以增强CLIP特征的细节表征。随后,GaussTR采用Transformer架构,从一组可学习的高斯查询初始化,通过可变形注意力聚合基础模型的局部特征,随后通过自注意力机制建模3D场景的全局关系。最终通过MLP预测头预测每个查询对应的高斯参数,包括位置μ、尺度S、旋转R、密度α、特征f,作为3D场景的表征。

“

基础模型对齐监督

在训练阶段,GaussTR采用可微分Gaussian Splatting将3D表征投影回2D视角得到渲染特征与深度,与2D视觉基础模型进行对齐监督,优化2D-3D表征的几何位置和跨模态一致性。此外,为了提升CLIP特征的语义特征的边界准确性,GaussTR可选地引入Grounded SAM生成的分割掩码,通过辅助语义头预测约束高斯特征渲染的类别概率。

“

开放词汇占据预测

在推理阶段,GaussTR利用CLIP共享的视觉-语言对齐的嵌入空间,计算预测的高斯特征与目标类别的CLIP文本向量之间的相似度得到每个高斯查询对应的类别概率,随后将高斯查询体素化生成最终的占据预测。由此,GaussTR可以在无需额外标注的情况下,实现零样本开放词汇预测。

实验结果

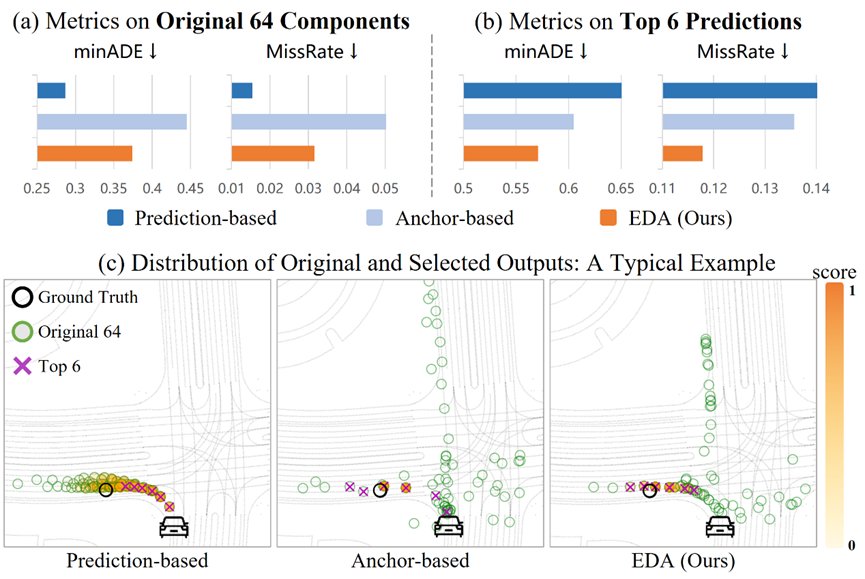

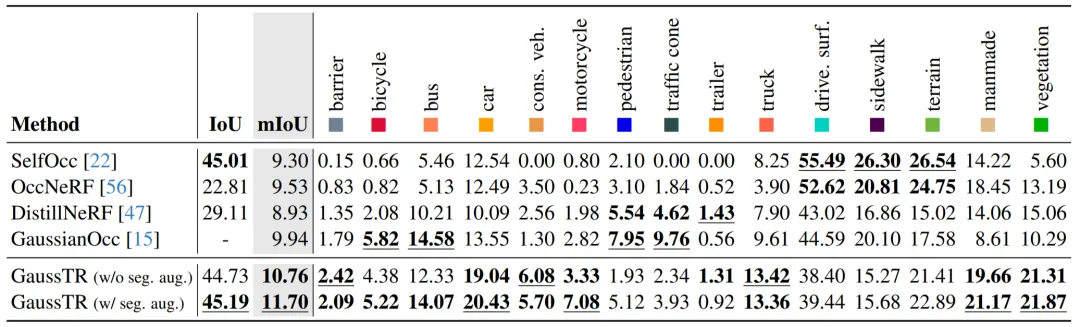

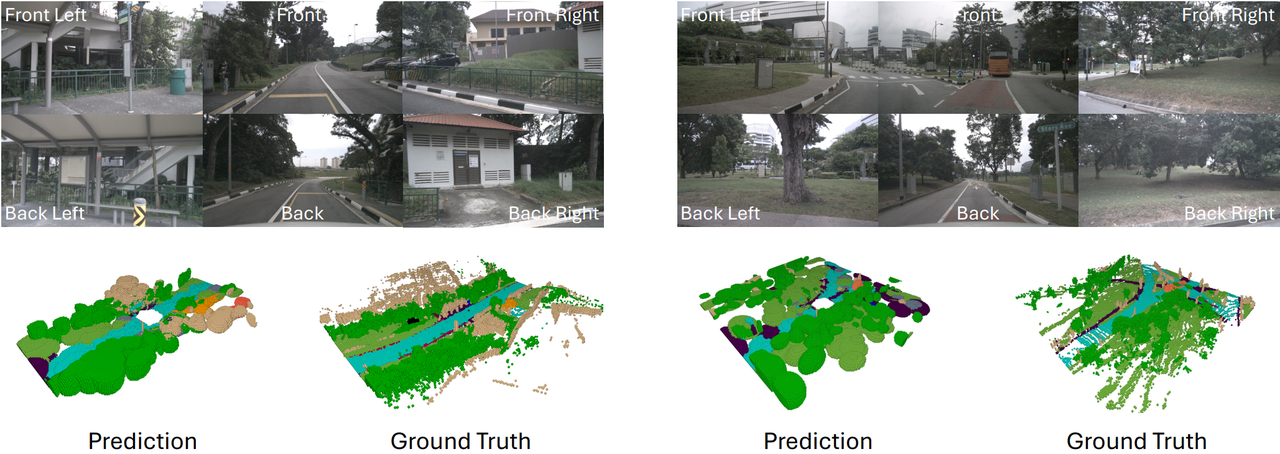

在Occ3D-nuScenes数据集上的实验评估表明,GaussTR取得了11.70mIoU的最先进性能,在现有算法的基础上提升了1.76mIoU。并且相较于依赖分割掩码伪标签的方法,GaussTR实现了零样本的开放词汇占据预测,进一步验证了基础模型对齐的通用3D表征学习能力。从逐类别的实验结果来看,GaussTR在以物体为中心的的类别上标展卓越,如车辆、建筑物和植被,这些类别的提升与我们提出稀疏建模策略的核心理念相契合。然而,GaussTR在小物体类别(如行人)和平坦表面类别(如道路)上表现相对较弱。造成这一现象的主要原因包括:小物体的视觉特征不够显著,在基础模型的预测特征中难以区分;驾驶场景中的大量遮挡,导致平坦表面的几何信息难以捕获。

从可视化结果来看,GaussTR预测的高斯分布展现了优异的整体场景结构,并且在物体局部细节的表现也更加精确,展现了出色的三维空间理解能力。

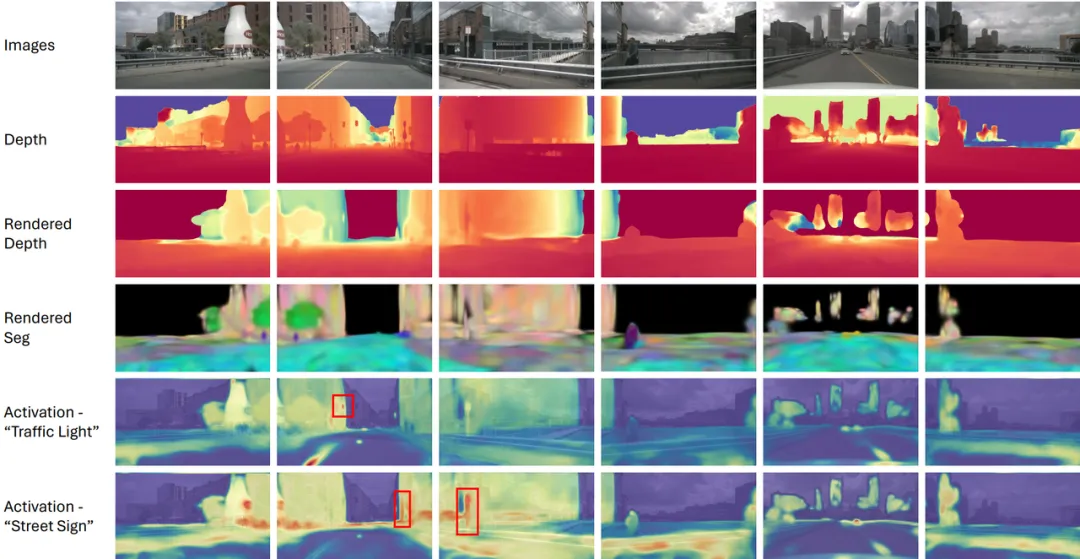

此外,我们对2D视角的渲染结果进行了可视化分析,尤其是数据集中未明确标注的罕见类别(如交通灯、街道标识)上的零样本预测效果,GaussTR依然能够在对应位置产生显著的激活。这一点进一步证明了GaussTR在3D表征学习的泛化能力,即使面对现实应用的长尾分布场景,仍能依靠基础模型的知识迁移实现准确的预测,为未来自动驾驶、具身智能等3D空间理解能力提供了新的方向。

总结与展望

本文介绍了一种基于基础模型对齐的稀疏高斯表征学习框架GaussTR,通过将3D高斯预测与2D视觉基础模型的知识对齐,实现了无需体素级标注的零样本自监督三维语义占据预测,为3D空间理解提供了一种高效且可扩展的新方案。

通过引入Transformer架构前馈生成稀疏高斯分布,配合可微分渲染的跨模态对齐范式,GaussTR在降低计算复杂度的同时,突破了传统方法对人工标注的依赖,在Occ3D-nuScenes数据集上取得11.70mIoU的自监督最先进性能,验证了基于基础模型知识迁移的3D表征学习有效性。实验表明,稀疏高斯建模策略能有效捕捉场景的语义拓扑结构,尤其在物体级语义建模上展现出显著优势。

未来,我们希望进一步探索基于可微分渲染构建跨模态对齐的通用表征范式,突破3D标注数据瓶颈,这一技术路径有望拓展至更广泛的3D感知任务,如动态场景理解、多智能体协同感知等复杂任务。同时,随着更强大的视觉-语言基础模型的发展,我们也期待能够构建更通用的3D语义表征,使得GaussTR能够在更复杂的现实场景中发挥作用,为自动驾驶、具身智能、增强现实等领域提供更强大的3D感知能力。

参考文献:

[1] Radford A, Kim J W, Hallacy C, et al. Learning transferable visual models from natural language supervision[C]//International conference on machine learning. PmLR, 2021: 8748-8763.

[2] Huang Y, Zheng W, Zhang B, et al. Selfocc: Self-supervised vision-based 3d occupancy prediction[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2024: 19946-19956.

[3] Zhang C, Yan J, Wei Y, et al. Occnerf: Advancing 3d occupancy prediction in lidar-free environments[J]. arXiv preprint arXiv:2312.09243, 2023.

[4] Wang L, Kim S W, Yang J, et al. Distillnerf: Perceiving 3d scenes from single-glance images by distilling neural fields and foundation model features[J]. Advances in Neural Information Processing Systems, 2025, 37: 62334-62361.

分享文章

欢迎订阅地平线相关资讯,您可以随时取消订阅。

感谢您的订阅, 我们会第一时间推送地平线最新活动与资讯到您邮箱

.

.